Szybkie analizy wielkich ilości danych, pomoc w rozwiązywaniu skomplikowanych problemów społecznych, ekonomicznych czy naukowych, rozwój nowej generacji produktów i usług, diagnozowanie chorób, a nawet leczenie autyzmu u dzieci – to możliwości i niewątpliwe zalety sztucznej inteligencji.

Ale każdy medal ma dwie strony. Pierwsi przekonali się o tym artyści, których interesy sztuczna inteligencja narusza, gdy bez ich wiedzy i zgody wykorzystuje dzieła będące wytworem ludzkich emocji, wyobraźni i talentu. I to bez jakiejkolwiek rekompensaty.

Niańka AI i chiński scoring

Czy chcielibyśmy oddać sztuczną inteligencję w ręce dzieci lub raczej dzieci oddać pod opiekę AI? Interaktywne zabawki, wspomagane przez czatboty, dopasowujące się do konkretnego dziecka, reagujące na komendy głosowe, opowiadające dziecku specjalnie wymyślone dla niego bajki – takie elektroniczne cuda szykuje firma z Hongkongu, jeszcze przed świętami mają trafić na rynek. Brzmi zachęcająco, ale pomyślmy – taka zabawka musi zbierać dane, by dopasować się do upodobań dziecka, więc nieustannie nagrywa otoczenie. Robi się nieswojo?

Idźmy dalej. Chcemy zapisać dziecko do prywatnego przedszkola, ale spotyka nas odmowa, bo… zalegamy z podatkiem. To się już dzieje, tyle że w Chinach. Ocenia się tam obywateli i przyznaje im punkty. Dodatnie dostaje się np. za działanie na rzecz partii rządzącej w Chinach, a ujemne za uczestnictwo w protestach, wykroczenia drogowe, opóźnienia w zapłacie podatków i składek.

To tzw. scoring społeczny (system zaufania społecznego), do którego mają dostęp nie tylko instytucje rządowe, ale również prywatne firmy. Im więcej punktów dodatnich, tym lepszy dostęp do benefitów takich jak możliwość posłania dzieci do dobrych szkół. Niska ocena powoduje natomiast utrudnienia w codziennym życiu, np. problem z uzyskaniem kredytu.

Scoring nie byłby możliwy bez AI analizującej dane z baz urzędów, instytucji finansowych, kamer monitoringu itp. Problem w tym, że systemy oceny oparte na sztucznej inteligencji niosą ze sobą ryzyko błędu algorytmicznego, ponieważ dane, na jakich szkolą się maszyny oraz modele decyzyjne, na których działają, odzwierciedlają ludzkie uprzedzenia i stereotypy. W efekcie może dojść do sytuacji, gdy bank odmówi pożyczki osobie niewidniejącej na żadnej „czarnej liście”, ale np. leczącej się onkologicznie.

Puchówka Franciszka a ryzyko wojny

A teraz coś z branży medialnej. Pamiętacie fotografię przedstawiającą akcję z aresztowania Donalda Trumpa? Albo zdjęcie papieża Franciszka w modnej białej puchowej kurtce? Trudno było się zorientować, że to obrazki wygenerowane przez sztuczną inteligencję.

Takie fejki byłyby może zabawne, gdyby nie fakt, że z pomocą AI można też wygenerować moment ataku palestyńskich terrorystów na izraelski Kneset. Deepfake może być także wykorzystywany przez przestępców do omijania systemów bezpieczeństwa, takich jak systemy uwierzytelniania biometrycznego.

Zatem fałszywe zdjęcia, filmy, nagrania audio ze sklonowanym głosem to nie tylko dezinformacja, ale także ryzyko zachwiania bezpieczeństwem kraju.

Ojcowie ostrzegają

Istnieje jeszcze poważniejsze ryzyko niekontrolowanego rozwoju i stosowania AI. Mówił o nim Alan Turing uznawany za ojca sztucznej inteligencji. Jego zdaniem domyślnym wynikiem rozwoju AI jest powstanie sztucznej superinteligencji, która byłaby w stanie mieć emocje i relacje, co doprowadziłoby do przejęcia kontroli nad światem przez maszyny.

Taki scenariusz dopuszcza też Center for AI Safety, które skupia wielu głównych graczy w branży AI. Organizacja ocenia, że „ograniczenie ryzyka wyginięcia ludzkości z powodu sztucznej inteligencji powinno być globalnym priorytetem, obok innych zagrożeń na skalę społeczną, takich jak pandemie i wojna nuklearna”.

Są również eksperci, którzy uważają, że sztuczna inteligencja nie wysadzi nam świata, ale stracimy przez nią zdolność samodzielnego dokonywania osądów i podejmowania decyzji, pogorszą się nasze doświadczenia niezbędne do przetrwania, jak chociażby umiejętność dostosowania się do nieoczekiwanych zdarzeń. ChatGPT już teraz eliminuje potrzebę samodzielnego pisania prac domowych w szkolnictwie. Czyli na naszych oczach nauczyciele tracą kluczowe narzędzie do weryfikacji, czy uczeń lub student nabył umiejętność krytycznego myślenia, która decyduje o rozpoznawaniu i odrzucaniu błędnych idei lub rozwiązań.

Zapobieganie zagrożeniom związanym z AGI wymaga szerokiej dyskusji na poziomie międzynarodowym oraz wspólnych wysiłków w opracowywaniu zasad i norm etycznych dotyczących rozwoju i stosowania superinteligencji.

Koło ratunkowe

Z zagrożeń zdała sobie sprawę także Unia Europejska. Jej Akt o sztucznej inteligencji (Artificial Intelligence Act) zaprezentowany w 2021 r. to pierwsza na świecie próba kompleksowego uregulowania prawnego systemów AI i ich zastosowań. Dokument, nad którym prace wciąż trwają, klasyfikuje systemy AI na czterech poziomach ryzyka:

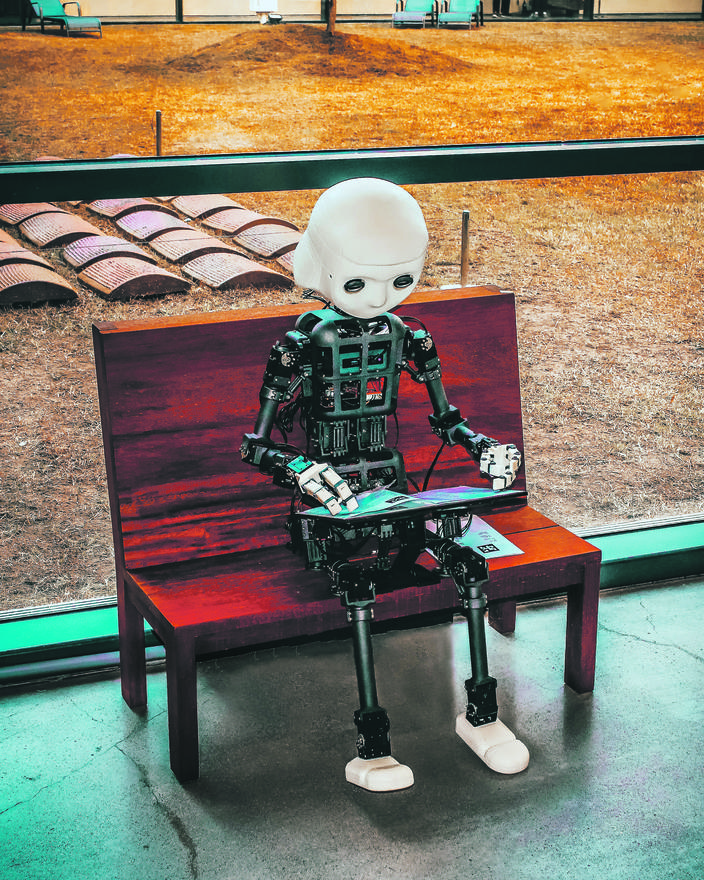

•Niedopuszczalne: profilowanie, identyfikacja biometryczna, scoring społeczny, zabawki – tu byłby zakaz stosowania AI;

•Wysokie: zatrudnianie, edukacja, zdrowie, transport, podstawowe usługi prywatne i publiczne – systemy AI w tych obszarach będą musiały spełniać surowe wymagania, zanim zostaną dopuszczone do stosowania;

•Ograniczone: czatboty, systemy automatyzujące procesy, np. administracyjne – użytkownicy powinni mieć świadomość, że wchodzą w interakcję z maszyną, by móc decydować o jej kontynuowaniu lub cofnięciu się;

•Minimalne: gry wideo z obsługą AI, filtry spamowe – niewymagające nadzoru państwa.

Ponieważ sztuczna inteligencja rozwija się w szalonym tempie, AI Act ma być skonstruowany tak, by przepisy można było dostosować również do przyszłych rozwiązań technologicznych. Ale czy to wyeliminuje zagrożenia?

Przyszłość według AI

Oto, co o tym sądzi ChatGPT, któremu zadaliśmy pytanie, czy AI Act zapobiegnie niebezpieczeństwom związanym z AGI: „AI Act stanowi ważny krok w regulowaniu i monitorowaniu stosowania sztucznej inteligencji w różnych obszarach. Jednakże, jeśli chodzi o potencjalne zagrożenia związane z AGI, czyli sztuczną inteligencją, która przewyższa ludzkie zdolności w szerokim zakresie dziedzin, AI Act sam w sobie może nie wystarczyć. Potencjał i możliwości AGI mogą wykraczać daleko poza obszary takie jak edukacja, zdrowie czy usługi publiczne, wpływając na zasadnicze aspekty ludzkiego życia i społeczeństwa. Zapobieganie zagrożeniom związanym z AGI wymaga szerokiej dyskusji na poziomie międzynarodowym oraz wspólnych wysiłków w opracowywaniu zasad i norm etycznych dotyczących rozwoju i stosowania superinteligencji”.

Dorota Jogars